13 octobre 2021

Jean-Baptiste Piccirillo

Manager Transformation Data

Nous entrons dans une ère où les actifs de l’organisation doivent être mis au service de l’essentiel. Il est temps de dire au revoir au data lake « fourre tout », et d’assurer la maîtrise des données essentielles pour la stratégie et la raison d’être de l’organisation. La gouvernance des données devra être pragmatique pour assurer que les investissements (stockages, traitements, compétences data, …) sont mis au service de ce qui compte vraiment.

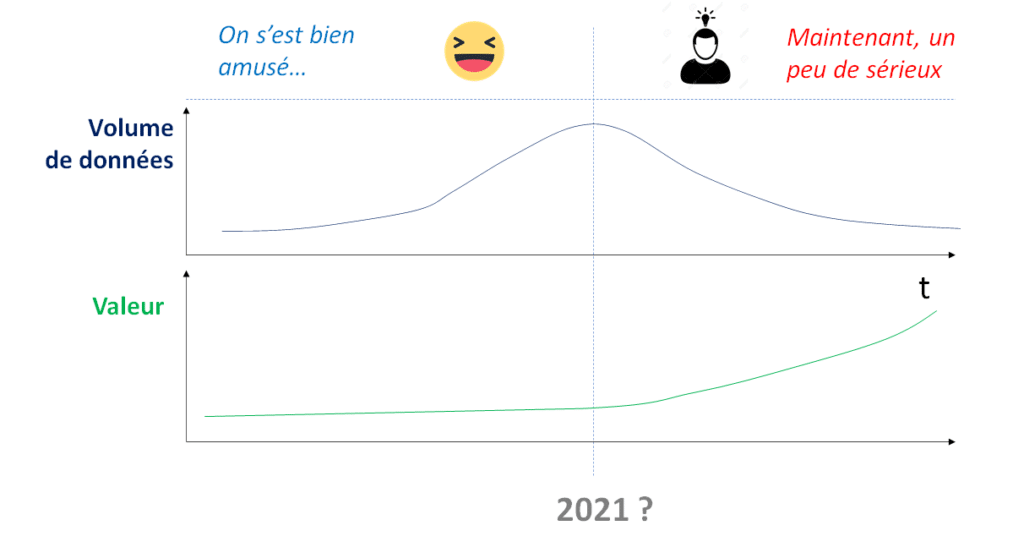

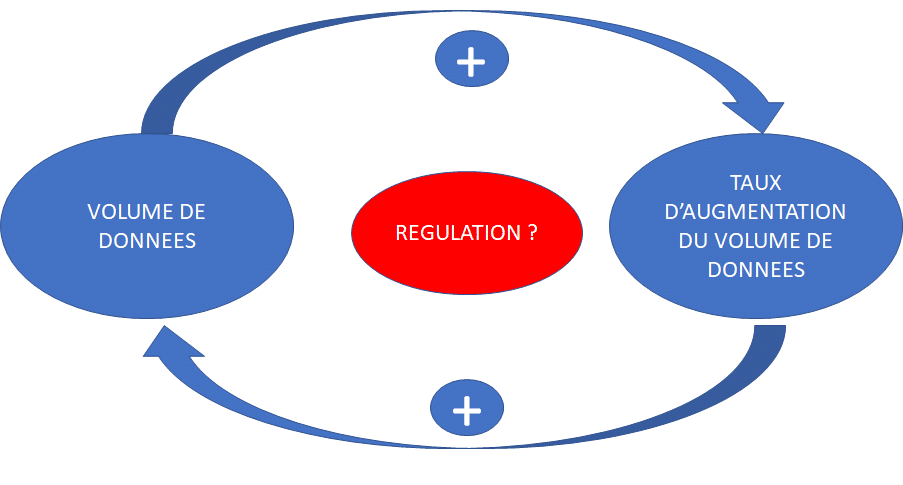

Le rôle du Chief Data Officer de 2021 est de réguler/minimiser au maximum les comportements automatisés ou humains qui génèrent toujours plus de volume, mais… pas toujours plus de valeur. Ces comportements prennent parfois la forme de boucles de rétroactions positives, non régulées. Il est temps de trouver le bon niveau de régulation pour limiter ces proliférations, vers plus de sobriété. Ce sera un bien pour votre portefeuille et pour l’environnement.

Voici un exemple de rétroaction :

Une donnée fait des petits (copies, données transformées pour des usages spécifiques, parfois ponctuels, ,..). Plus les volumes de données stockées sont importantes dans votre organisation et plus l’augmentation de ces mêmes volumes demain aura tendance à être grande. Duplication des données, copier coller à droite à gauche… Sans une gouvernance aboutie des données en guise de régulation : plus il y a de données… plus il y aura de données, sans même que vous l’ayez demandé ou voulu ! Au même titre que plus il y a de gens sur cette planète, plus il y aura de naissances…

Quelles régulations ?

Faire le tri dans vos données existantes, c’est comme faire le tri dans votre appartement après une grosse dépression : C’est le « bordel ». Vous devez ranger. Vous commencez par enlever tout ce qui n’a clairement rien à faire là et qui n’est pas utile (les déchets, les vieux papiers sans utilité, …), vous remplissez quelques poubelles sans trop d’état d’âme. Puis vient l’étape plus minutieuse, où vous prenez le temps par catégorie. Vous vous posez vraiment la question : « Dans ce qui reste, de quoi puis-je me passer ? ». Alors vous triez en paquets « je garde, je ne peux pas m’en passer », « ça peut, peut être, servir », « je suis décidé, je m’en débarrasse ».

Pour les données c’est pareil. Il y a toujours des petits malins pour dire : « Gardons l’historique, après tout, ça peut peut être servir un jour, c’est le principe du data lake non ? » Non, parce qu’une donnée stockée a un coût environnemental et financier, si on ne sait pas dire simplement pourquoi elle est là, alors elle n’a pas à être là. Fin de la partie. « Delete »… Dans l’ère du « Big Data », ce réflexe n’est pas naturel (c’est le moins qu’on puisse dire) et pourtant il est précieux, et vous évitera bien des problèmes, plus qu’il ne vous fera manquer d’opportunités…

L’ajout d’une nouvelle donnée doit être justifiée « by design ». Une application sera conçue en appliquant le principe de « Data Minimization », pas seulement pour les données personnelles mais pour toutes les données. Si la valeur de la donnée n’est pas avérée, alors on ne demande pas à l’utilisateur de la saisir. L’UX n’en sera que plus épurée, et ça fera un problème de moins à gérer, et un bienfait pour la charge mentale de vos utilisateurs, clients, collaborateurs.

La gouvernance des données doit intégrer dans son ADN ce principe simple et parfois oublié : une donnée qui n’a pas d’usages clairement qualifiés n’a rien à faire dans les bases de données de votre organisation.

Et malheureusement, l’augmentation des volumes peut générer rapidement des pertes de qualité

Parce que plus il y a d’objets et de meubles dans votre appartement, plus il faut prendre du temps pour nettoyer…Il faut bouger les meubles pour nettoyer derrière, soulever les objets pour nettoyer en dessous… Vous n’y échapperez pas, pour les données c’est pareil. La gouvernance des données doit assurer le coup de chiffon qui va bien au bon moment pour limiter les risques de non qualité ou de sécurité, et réduire l’empreinte carbone du système d’information.

Voilà un challenge que le Chief Data Officer devrait s’approprier davantage à l’échelle de son organisation. Maîtriser les volumes et la prolifération des données, pour être capable de maintenir un niveau de qualité acceptable, et documenté : Un utilisateur ou un projet doit être alors capable en toute autonomie de décider si le niveau de qualité de l’information est suffisant pour l’usage qu’il veut en faire, et, si son usage le justifie, qualifier des exigences de qualité supérieur à ce qu’il a aujourd’hui (fraicheur, complétude, ..) avec les équipes en charge des données.

C’est également la juste contribution du CDO dans les prochaines années à la maîtrise de l’empreinte carbone du numérique, en régulant la masse de ses actifs data plus sérieusement qu’il ne le fait aujourd’hui.

Moins de volume ET plus de valeur : Vous relevez le défi ?