18 janvier 2019

– 5 min de lecture

Valentin Defour

Consultant Senior Transformation Data

Data scientist, data analyst, data cruncher,… ces dernières années, le nombre d’intitulés de postes relatifs au traitement, et plus particulièrement à l’analyse, de données a explosé. On constate également la popularité croissante des compétences inhérentes à ces postes via divers tops ‘in-demand skills’, publiés annuellement sur LinkedIn. Ces postes ont tous une compétence requise en commun, l’analyse de données, aujourd’hui jugée primordiale dans le monde professionnel par le cabinet Gartner, jusqu’à l’élever au rang de norme.

Mais ne sommes-nous pas déjà entrés dans une nouvelle époque, durant laquelle les composantes basiques de ces compétences vont peu à peu migrer dans le ‘savoir commun’ et devenir des pré-requis pour un scope plus large de métiers ? Ne sommes-nous pas entrés dans l’ère de la ‘data democratization’ ?

Pourquoi une explosion de de la demande relative à ces compétences ?

A l’heure où plus de la moitié de l’Humanité a quotidiennement accès à Internet et où 90% des données disponibles ont été créées dans les deux dernières années, toute entreprise collecte et stocke une quantité importante de ces données. De formats et types variés, ces dernières sont également transversalement issues de la totalité des métiers de l’organisation. Les capacités de traitement (stockage et puissance de calcul, ‘asservis’ à la loi de Moore depuis des décennies) ont elles aussi explosé, passant d’un statut de facteur limitant à celui de non-sujet.

Traditionnellement, ces données étaient propriétés de la DSI. Certes, les décisions des BU métiers et du top management s’appuyaient déjà sur ces données. On ne pouvait toutefois pas se passer d’un intermédiaire pour leur consultation et traitement, augmentant les risques de non compréhension de la donnée ainsi que les temps de traitement des demandes. Aujourd’hui, de plus en plus d’organisations transversalisent leur entité ‘data’, afin de rapprocher les données des métiers, porteurs de la connaissance de la donnée, et des usages, délivreurs de valeur.

Car il est évident que, bien qu’elle soit complexe à déterminer précisément et instantanément, la donnée a une valeur évidente qu’il convient d’exploiter. Pour cela, une capacité d’analyse, plus ou moins poussée, est nécessaire à tous les niveaux de l’entreprise, au plus proche de la donnée et ce pour ne pas en perdre la signification.

Mais il existe encore des freins à cette démocratisation. En entreprise, le nouvel analyste peut se heurter à une mauvaise compréhension de la donnée. Même si la tendance est au partage et à la “transversalisation”, les données sont encore parfois stockées et gérées en silo, rendant difficile l’accès et la transparence de la signification métier de cette donnée.

Mais multiplier les analystes peut aussi représenter un risque de multiplier les analyses…identiques. Aussi, un sujet apparaît lorsque la donnée est rendue accessible plus largement : celui de la protection des données personnelles, récemment encadré par la nouvelle réglementation GDPR. En effet, la finalité d’un traitement de données doit aujourd’hui être systématiquement précisée, tout comme la population de personnes accédant aux données en question. Cette dernière doit par ailleurs être réduite au strict minimum et justifiable.

Cette data democratization est donc porteuse, dans le monde de l’entreprise, d’un message supplémentaire : une gouvernance bien établie agrémentée d’une communication efficace sont nécessaires et catalyseront la démocratisation.

Et concrètement, analyser des données ?

Avant toute chose…

Il existe une règle d’or dans le monde de l’analyse de données et elle s’appliquera également aux nouveaux analystes issus de la data democratization. Cette règle, éprouvée et vérifiée, stipule qu’en moyenne 80% du temps effectif d’un analyste sera consommé par la collecte, le nettoyage l’organisation et la consolidation des données, ne laissant que les 20% restants pour les analyser et en tirer de la valeur. Il faut donc que les nouveaux analystes prennent conscience de cette contrainte et aient une base de connaissances sur les réflexes de vérification à avoir lors de la réception d’une nouvelle source de données.

Visualiser

On peut définir la visualisation de données (ou dataviz) comme une exploration visuelle et interactive de données et leur représentation graphique, indépendamment de leur volumétrie, nature (structurées ou non) ou origine. La visualisation aide à percevoir des choses non évidentes en premier lieu, répondant à deux enjeux majeurs du monde de l’entreprise : la prise de décision et la communication.

Mais attention, un graphique mal utilisé peut faire passer un message erroné, laisser percevoir une tendance peu fiable ou maquiller une réalité. C’est donc pour cela qu’il convient de donner à tous une base méthodologique permettant d’exploiter la puissance de la dataviz tout en évitant les écueils.

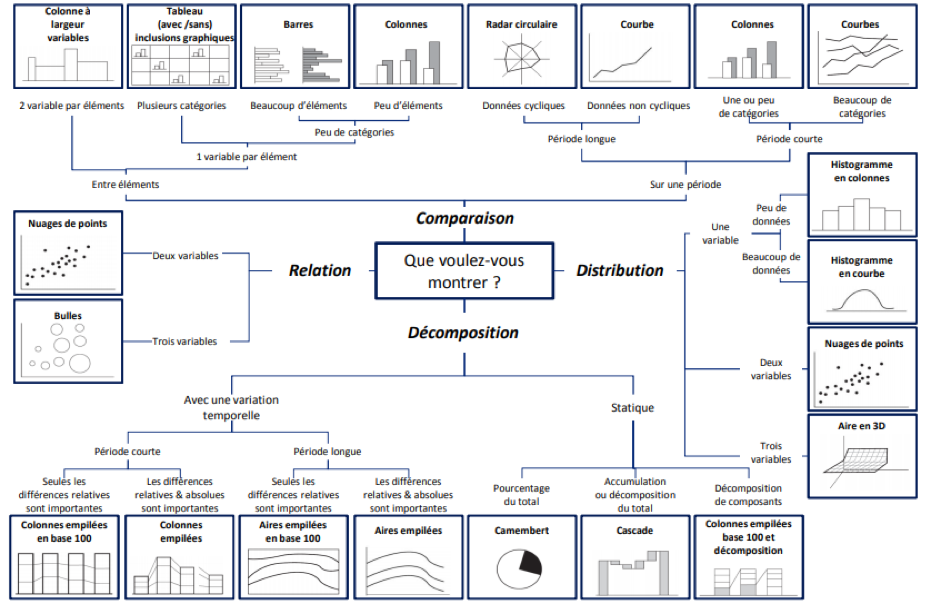

La force de la visualisation réside en l’aperçu instantané qu’elle permet d’avoir sur une large quantité de données, pour peu que son créateur ait fait le bon choix de représentation. Plusieurs paramètres sont à considérer lorsque l’on souhaite choisir une visualisation : quel phénomène je souhaite mettre en évidence ? de combien de variables ai-je affaire ? ma représentation doit-elle être continue ou discrète ? …

Ci-dessous, une cheatsheet sous forme de visualisation, avec pour thème :

“Quel type de graphe pour quel usage ?”

Avec quels outils, pour commencer ?

Une des raisons d’occurrence de cette ‘data democratization’ est l’émergence de technologies facilitatrices, permettant à un plus grand nombre d’interagir avec les données, à l’aide de frameworks de code ou d’interfaces graphiques accueillantes pour une expérience guidée et visuelle :

- Logiciels de ‘data federation’ et dataviz : des interfaces graphiques simples, guidant la manipulation de l’import des données de formats et de sources différentes jusqu’à leur visualisation, intégration dans des dashboards et publication de rapports. On peut citer les solutions leaders du marché : Tableau Software, QlikView, Microsoft Power BI,…

- Solutions “all included” et plateformes : dans une unique application, la possibilité est donnée de mener des analyses automatiques jusqu’à de la modélisation complexe, le tout sans avoir à toucher (ou peu) une ligne de code (exemples de solutions : IBM Watson Analytics, Dataiku, Saagie,…)

- Frameworks et librairies : s’adressant à un public plus averti, il s’agit là de fonctions et méthodes prêtes à être ré-utilisées et adressant des problématiques et utilisation bien particulières (exemples : librairies NumPy et Pandas en Python pour faciliter la manipulation de données, librairie D3js en JavaScript pour la dataviz, …)

Mais il est toutefois un outil encore très majoritairement utilisé pour des cas simples de reporting, visualisation, agrégation et modélisation simple. Il s’agit du tableur on-ne-peut-plus-classique : Excel et l’ensemble de sa cour d’alternatives (GSheets, LibreOffice Calc,…). Et il est évident que l’on ne peut pas parler de démocratisation sans citer cet outil.

L’utilisation du tableur est aujourd’hui un pré-requis pour un grand nombre de métiers, dont certains sans aucun rapport à l’informatique. Aussi, le niveau de compétence en la matière n’a fait que s’élever d’années en années et c’est une tendance qu’il convient d’accompagner. De son côté, Microsoft ne cesse d’enrichir les fonctionnalités et, paradoxalement, de simplifier l’utilisation de son outil, en ajoutant des suggestions basées sur une analyse intelligente des contenus.

Notre conviction

Bien que nous n’ayons aujourd’hui pas le recul pour l’affirmer, on peut avoir bon espoir que cette démocratisation révolutionne la prise de décision en entreprise, en permettant aux employés à tous les niveaux de l’organisation d’avoir accès à des données et d’en tirer conclusions, plans d’action et projections.

Et nous pouvons espérer que cette démocratisation ne se cantonne pas au périmètre de l’entreprise traditionnelle : quid du travailleur indépendant, du petit commerçant ou du restaurateur ? Il est évident que ces individus également, dans l’exercice de leur activité, génèrent ou reçoivent des données qu’ils pourraient exploiter et valoriser (optimisation des stocks, analyses de résultats,…). Pour ces professionnels, un minimum de compétence internalisée mènerait à des économies en prestations et en temps passé, mais également à un éventuel ROI issu de l’analyse et de l’exploitation de leurs données.

Forts de ces constats, nous nous sommes aujourd’hui forgé la conviction suivante :

Nous sommes tous analystes de données !

Sources