28 novembre 2019

– 6 min

Valentin Defour

Consultant Senior Transformation Data

Le 8 Avril dernier, le ‘High Level Expert Group on AI’, sorte d’Avengers de l’Intelligence Artificielle dépêchés par la commission Européenne, présentait ses recommandations en matière d’éthique de l’IA. Basé sur une consultation publique ayant recueilli plus de 500 commentaires, ce rapport pointe, entre autres, le sujet du biais algorithmique et met en garde les acteurs de l’IA sur les conséquences négatives que ce dernier peut entraîner, de la marginalisation des minorités vulnérables à l’exacerbation des préjugés et des discriminations. Il présente ainsi les systèmes d’IA comme devant être de véritables acteurs de la diversité en impliquant dans leur développement la totalité des parties prenantes.

Des algorithmes racistes ?

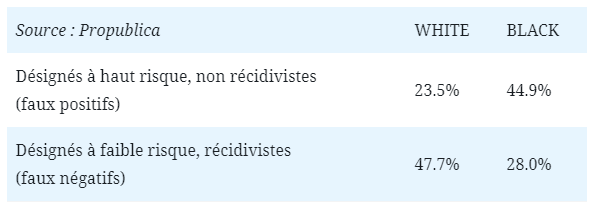

Il y a aujourd’hui quelques années, Propublica, média indépendant d’investigation américain, publiait une étude simplement intitulée “Machine Bias”. Son message : C.O.M.P.A.S. (pour Correctional Offender Management Profiling for Alternative Sanctions), un algorithme largement utilisé dans les cours de justice américaines, serait racialement biaisé, avec pour effet de désigner comme potentiels récidivistes un trop grand nombre de personnes noires. Par la suite, l’expérience a démontré que le nombre de faux positifs chez la population noire était bien plus élevé que celui constaté du côté de la population blanche, comme relaté ci-dessous :

Tim Brennan, professeur de statistiques à l’université et co-fondateur de l’algorithme C.O.M.P.A.S., expliquait déjà que le concept de ‘race’ était selon lui difficile à complètement exclure du calcul de score, car également corrélé à des indicateurs indispensables pour l’algorithme tels que le niveau de pauvreté du prévenu, le taux de chômage constaté dans son quartier, … Retirer également ce type de données du calcul de score entraînerait selon lui une chute de la précision du prédicteur, précision alors quantifiée à 68% (précision : nombre de véritables récidivistes / nombre de récidivistes désignés). En aparté, on s’interroge déjà sur cette valeur qui, en pratique, image le fait qu’une personne analysée sur 3 serait désignée comme récidiviste, à tort. Même si les cours pénales américaines n’appliquent pas à la lettre le résultat de l’algorithme, on imagine bien l’influence de ce dernier concernant la décision finale…

L’étude de Propublica, complétée des datasets utilisés

Quelques définitions…

Une manière simplifiée d’expliciter un algorithme serait de le décrire comme une liste finie d’instructions s’enchaînant selon des conditions logiques, produisant potentiellement une sortie en fonction d’aucune, une ou plusieurs entrées. Ainsi, peuvent être considérés comme algorithmes une recette de cuisine, un itinéraire GPS ou un ensemble d’instructions médicales. Appliqués au monde informatique, on peut les qualifier d’algorithmes numériques, transformant une ou plusieurs données d’entrée en une ou plusieurs sorties numériques. Ainsi, une simple formule qui, en considérant l’âge, le statut de fumeur, la pression artérielle et quelques autres caractéristiques d’un individu afin de prédire un risque d’AVC est un algorithme.

De manière plus précise, les algorithmes que nous adresserons dans cette suite d’articles sont ceux relatifs au machine learning, littéralement « apprentissage machine ». Soit la capacité pour un programme d’apprendre d’expériences passées pour anticiper des événements futurs. Nous nous focaliserons sur les algorithmes supervisés : ils ont besoin d’un grand nombre d’exemples en entrée pour pouvoir exercer sur une nouvelle situation ou événement à prédire. On retrouve tout un ensemble de situations où l’apprentissage supervisé est utile : reconnaître des personnes sur une photo, filtrer des spams dans une messagerie ou encore prévenir d’un risque de défaut de remboursement de crédit.

Le phénomène de biais, quant à lui, peut prendre plusieurs significations selon le contexte dans lequel il est nommé. Nous nous concentrerons ici sur les définitions englobées dans le spectre “statistiques appliquées”, mais il faut savoir que ce terme, en plus d’être le nom de bourgades du Lot-Et-Garonne et de la Virginie Occidentale, est applicable à de nombreux domaines (électronique, psychologie, …).

De manière non exhaustive, en statistiques appliquées, ce biais peut être de plusieurs types :

- biais d’échantillonnage (données en entrée non représentatives de la réalité),

- biais de mesure (mesurer un résultat selon tel ou tel indicateur),

- biais d’auto-complaisance ou de publication (directement lié au biais cognitifs humains, le fait de ne publier des résultats que s’ils sont en accord avec ses propres croyances personnelles),

- et bien d’autres…

Quel rapport avec les systèmes d’IA ? Eh bien ce sont ces biais statistiques qui se trouveront exprimés dans les modèles, du fait de la sélection des données d’entrée, de l’expression plus ou moins marquée de certains features du modèle ou encore de l’interprétation des résultats. C’est ainsi que, fonctionnellement, des algorithmes peuvent “accoucher” de résultats fonctionnellement biaisés : biais raciaux, de genre, d’âge, …

Le risque ?

De plus en plus de décisions sont aujourd’hui prises par des algorithmes. De l’analyse automatique des CV à celle des dossiers de demande de prêts, de l’ordre des publications sur un réseau social à la liste de publicités affichées sur le net, ces algorithmes prennent une place de plus en plus importante dans nos vies quotidiennes. C’est pourquoi y inclure, volontairement ou non, des biais de toute sorte représente un danger important. Il est certain que ces décisions, autrefois prises par des humains, étaient déjà sujettes aux différents biais cognitifs. Mais c’est bien l’industrialisation de ces biais qui pose le problème.

Big data doesn’t eliminate bias, we’re just camouflaging it with technology

Cathy O’ Neil

En considérant un algorithme, régi par des préceptes mathématiques, on pourrait penser que ce dernier est objectif par définition et dénué des biais qui peuvent affecter les décisions humaines. C’est le principe du MATHWASHING, derrière lequel beaucoup de décisions algorithmiques ont été dissimulées.

Mais alors pourquoi cette objectivité algorithmique et mathématique serait-elle une illusion ?

Les algorithmes sont conçus par des humains

Leurs créateurs sont en charge de décisions structurantes telles que le périmètre de données à utiliser, les éventuels poids attribués à ces données, … Et, par définition, les décisions humaines sont biaisées, volontairement ou non. Par exemple, utiliser des données de genre pour déterminer quelles annonces d’emploi mettre en avant sur la page LinkedIn d’un individu a eu pour effet de recommander, en moyenne, des offres moins rémunérées pour les utilisatrices.

Les données en entrée sont également subjectives

Les algorithmes traitent les données qu’on leur présente en entrée. Ni plus, ni moins, sans avoir la possibilité d’évaluer leur caractère biaisé. En effet, les données reflètent toutes sortes de biais sociétaux bien ancrés, en plus d’en perpétrer des anciens. Quid de l’utilisation de données raciales dans un pays qui prônait la ségrégation raciale un demi-siècle plus tôt ? Quid de l’éradication du pay gap quand la plupart des données utilisées pour entraîner les algorithmes reflètent ce problème majeur de société comme une situation normale, ou au moins nominale.

Ainsi, cette amplification du biais peut être accidentelle (utilisation involontaire de données biaisées) mais également réalisée en toute connaissance de cause et d’effet, soit dans un but de manipulation de la décision algorithmique (ex : design de la ‘Gerrymandering map’ optimale), soit encore dans une optique de dé-responsabilisation : l’algorithme encaisse ainsi la responsabilité des décisions biaisées prises par les humains sur son bon conseil.

En résumé,

Ces considérations viennent alimenter un spectre plus large de problématiques relatives à l’éthique de l’IA. Il va sans dire que l’explicabilité de l’IA est un défi pour la suite de l’ère IA dans laquelle nous sommes entrés depuis quelques années. On connaissait le problème classique d’éthique de l’IA imagé par le MIT sur son site ‘Moral Machine’. Celui-ci permet, à l’aide d’une mise en situation, de sensibiliser les utilisateurs aux choix difficiles effectués par les IA embarquées dans les voitures autonomes. Dans le même esprit, myGoodness interroge sur l’attribution de sommes d’argent à des causes humanitaires ou avec objectif d’enrichissement personnel.

L’utilisation d’algorithmes d’intelligence artificielle est une forte opportunité de progrès technologique, et ce de manière très transverse. Toutefois, une perte globale de confiance en leurs résultats pourraient entraîner ce pan important de la recherche dans un nouvel hiver de l’IA si jamais leur caractère objectif venait à être décrié et leurs biais prouvés. Il en va donc de la responsabilité de leurs créateurs d’en faciliter la transparence, de leurs utilisateurs d’en vérifier l’accord avec les lois et de la totalité de la population d’exercer une pensée critique vis à vis des résultats obtenus.

Comprendre la limite des algorithmes aidera à juger leurs recommandations. De par leur définition, données et algorithmes réduisent une réalité complexe à une vision plus simple du monde. Seules les parties mesurables de cette vision devraient être utilisées. Il convient ainsi d’éviter la religion de l’algorithme et la vision réductrice inhérente, en gardant des décideurs humains dans la boucle du choix.

Dans une seconde partie, nous nous concentrerons sur les différentes approches existantes permettant de réduire voire d’éradiquer ces biais algorithmiques, pour des systèmes aux décisions plus justes et peut-être un jour réellement objectives…

Note : l’étude menée par Propublica sera par la suite fortement contestée par une étude gouvernementale. Indépendamment de la véracité des résultats, Propublica aura mis sur la table le sujet du biais algorithmique et l’aura rendu compréhensible (à minima accessible) au plus grand nombre.